Содержание

1. Введение ____________________________________________________ 2

2. Общие сведения о проблеме ____________________________________ 3

3. Краткий обзор

________________________________________________ 5

3.1. Продукты Oracle

________________________________________ 5

3.2. Продукты Convera _______________________________________9

3.3. Система ConExT ________________________________________ 11

3.4. OntosMiner

_____________________________________________ 16

3.5.

Язык

OWL

_____________________________________________ 18

3.5.1. Общие сведения

_____________________________________18

3.5.2. Веб-онтологии OWL _________________________________19

3.6. Медиалогия ____________________________________________ 26

3.7. Программа Starlight 3.0 ___________________________________29

3.8. UIMA(IBM) ___________________________________________ 30

3.8.1. Общие сведения _____________________________________ 30

3.8.2. Пример простого приложения в UIMA __________________ 32

3.8.3. Перспективы развития UIMA _________________________ 32

3.9. Комментарии к обзору ___________________________________ 34

3.9.1. Основные решаемые задачи ____________________________34

3.9.2. Общие выводы _______________________________________36

4. Проекты, поддержанные РФФИ_________ ________________________ 39

4.1. Проект 2002-2004 гг. _____________________________________ 39

4.1.1. Основная концепция __________________________________ 39

4.1.2. Априорная модель данных _____________________________42

4.1.3. Тестирование ________________________________________ 45

4.2. Проект 2005-2007 гг. _____________________________________ 47

4.3. Рекомендации по использовании результатов проектов ________ 48

4.4. Данные и знания ________________________________________51

5. Cервисно-ориентированная архитектура __________________________54

5.1. Общие сведения о СОА __________________________________54

5.2. Новая коммуникационная подсистема Windows – Indigo ______ 56

6. О компьютерной лингвистике

__________________________________ 59

7. Когнитивные методы принятия решений

_________________________ 61

7.1. Когнитивные методы в социально-политической сфере _______63

7.2. Когнитивные методы в экономике _________________________64

8. Заключение

__________________________________________________ 67

Литература _______________________________________________ 68

Дополнительные материалы 2006 – 2007 гг._________________________70

1. Введение

Главная

цель данных материалов – дать общее представление о современном состоянии

проблемы анализа больших объемов

текстовой информации из глобальной сети и алгоритмов принятия решений на

основе когнитивных методов. Основное

внимание уделялось содержательной стороне проблемы, в качестве фоновой рассматривалась задача

реализации соответствующих алгоритмов на параллельных системах (сеть

кластеров). При подготовке использованы материалы до

Материалы представляют собой в

основном извлечения из описания соответствующих систем, при этом по возможности

соблюдался баланс между слишком поверхностном описании и нагромождением деталей,

за которыми трудно полноценно оценить предлагаемые концепции.

Материалы не подвергались существенной аналитической обработке, они рассматривались как некоторый первичный экспериментальный базис. Тем не менее экспресс-анализ данных материалов укрепил уверенность автора в перспективности выбранного направления фундаментальных исследований, но надеемся не лишил автора способности видеть трудности проблемы.

2. Общие

сведения о проблеме

Одна

из основных целей анализа больших объемов

текстовой информации – высокорелевантный поиск в сети Интернет

и представление

неструктурированной текстовой информации

из сети Интернет в

структурированном виде, позволяющем осуществить последующую обработку (в

частности оперативный анализ – OLAP и интеллектуальный анализ – Data Mining) для систем принятия решений. Актуальность

данной проблемы определяется тем, что в

настоящее время соотношение между информацией, которую можно "читать",

и той, что можно "считать", составляет порядка 80:20. Аналитическая

обработка неструктурированной информации ориентирована в первую очередь на тексты, хотя в обозримой перспективе речь

может идти также о графике, звуке и видео.

Анализ

больших объемов текстовой информации по

сути является одной из частных проблем общей и фундаментальной проблемы

автоматической обработки естественного языка (ЕЯ). Другими частными проблемами

такого класса являются, например, проблема машинного перевода,

вопросно-ответные системы с ЕЯ-интерфейсом (в частности, доступ к базам данных

на ЕЯ), проблема автоматического индексирования документов, проблема

содержательного поиска в Интернет (более глубокого и тонкого, чем по ключевым

словам) и т.п.

По

мнению многих специалистов в области искусственного интеллекта (ИИ) решение

всех этих проблем существенно зависит от проблемы представления знаний (knowledge representation)

или как сейчас модно говорить от выбора онтологии предметной области. Эта центральная проблема ИИ еще далека от

удовлетворительного решения, хотя отдельные подходы были развиты

десятилетия назад (формулы исчисления

предикатов, семантические сети, фреймы, продукционные правила). Проблема представления знаний практически не

обсуждается в рамках данных материалов, один из аспектов этой проблемы очень

кратко затронут в заключении.

Проблема

анализа больших объемов текстовой информации из глобальной сети приобретает особую актуальность в связи

с постоянным ростом объемов информации

не только в Интернет, но и в

масштабе отдельных организаций. Аналитические отделы как в государственных

учреждениях (например ФАПСИ), так и в

крупных коммерческих структурах ежедневно получают много мегабайт текстовой

информации ( например, из СМИ). По этой информации достаточно оперативно

(обычно также ежедневно) аналитики представляют

руководству обобщенные сводки, в концентрированном виде отображающие суть

текстов.

Автоматизация

анализа позволяет существенно облегчить задачу аналитика и такие системы были разработаны и используются по

настоящее время, но их качество уже не удовлетворяет пользователей по мере

роста объемов текстов. Кроме того, c

появлением систем извлечения знаний (Data Mining) аналитика интересуют

автоматически выявляемые закономерности в данных. Однако системы Data Mining работают со структурированной информацией (в

базах данных, точнее в хранилищах данных - Data Warehouse). Поэтому помимо получения оперативных

сводок по массивам текстов, результат автоматического анализа целесообразно

представить в структурированном виде и далее использовать средства извлечения

знаний.

К

когнитивным методам и моделям анализа данных наряду с Data Mining относится и OLAP-технология (оперативный анализ данных). Эта

технология также работает лишь со структурированной информацией и следовательно

результаты анализа больших объемов текстовой информации целесообразно

использовать и для нее. Алгоритмы реализации OLAP и Data Mining не рассматриваются в данных материалах.

Подчеркнем, что все вышеупомянутые алгоритмы в конечном счете

включаются в системы поддержки принятия решений (DSS,

Decision Support System) и должны обеспечить компетентных лиц

достоверной, полной и достаточно компактной информацией для принятия важных

решений. Хотя как указано выше подходы OLAP и Data Mining ориентированы на структурированные данные, развитые в них механизмы могут быть полезны и при

обработке текстовой информации

OLAP – технология оперативной аналитической

обработки данных, обеспечивающая быстрый и наглядный ответ на достаточно

произвольные запросы аналитика. Цель OLAP анализа – проверка возникающих у аналитика гипотез. Технология OLAP оперирует с многомерными моделями данных

(т.н. гиперкубы ) и включает такие базовые операции как срез, вращение,

консолидация и детализация. Типичное время обработки запроса в OLAP-системе – несколько секунд (1 - 3).

Data Mining – технология позволяет обнаружить в данных

скрытые закономерности, практически полезные и доступные для интерпретации

человеком. Технология ориентирована на получение достаточно нетривиальных

закономерностей, которые трудно получить более простыми способами (например,

визуальным просмотром). Основными задачами анализа с привлечением Data Mining являются: классификация/регрессия,

нахождение частых зависимостей между объектами или событиями (ассоцитивные

правила), выделение групп объектов (кластеризация).

Типичные сферы практического

применения Data Mining:

-

Интернет-технологии

- рекомендательные системы

интернет-магазинов

- автоматическое распределение клиентов по

классам

- обнаружение безопасности при операциях с

пластиковыми картами

- персонализация посетителей Web-сайтов

- Торговля

- анализ рыночных корзин

- связи между покупками и временем

- сегментация рынка

- Телекоммуникации

- выявление категорий клиентов с похожими

стереотипами поведения

- Промышленость

- прогнозирование качества изделий от

параметров технологического процесса

- Медицина

- предсказание исхода назначенного курса

лечения

- исследование закономерностей в

генетических структурах

- исследование новых препаратов на

дофармакологической фазе

- Банковское дело

- решение о кредитоспособности клиента

(тысячи американских банков)

- Страховой бизнес

- предсказание страховых рисков

3. Краткий обзор

Цель обзора – получение относительно представительного первичного базиса для экспресс-анализ проблемы обработки больших объемов текстовой информации и разработок коммерческого уровня (в основном на Российском рынке).

3.1. Продукты Oracle

Лидер мирового рынка СУБД Oracle уже снабдил разработчиков

информационных систем рядом передовых технологий [1]. Речь идет о interMedia Text, входящем в состав СУБД

ORACLE8i, при использовании которого обработка текста сочетается со всеми

возможностями, предоставленными пользователю Oracle для работы с реляционными

базами данных. В частности, при написании приложений стало возможно использовать

SQL с развитым языком запросов к полнотекстовой информации.

Не останавливаясь подробно на всех уникальных возможностях

interMedia Text, информацию о которых можно получить на сайтах www.oracle.com и www.oracle.ru, отметим, что, к

сожалению, большинство из них оказывается доступно в полной мере лишь на

английском языке.

Адаптацией технологий Oracle к русскоязычным полнотекстовым

базам данных занимаются специалисты компании «Гарант-Парк-Интернет». Продукт

этой компании под названием Russian Context Optimizer (RCO) предназначен для

совместного использования с interMedia Text.

RCO - Серия

продуктов, выпускаемых под маркой RCOТМ, предназначена для поддержки

широкого класса систем, использующих средства поиска и анализа текстовой

информации, таких, как информационно-поисковые и аналитические системы,

электронные архивы и системы управления документооборотом. Продукты серии RCO

задействуют передовые технологии обработки текста, лингвистические и математические

алгоритмы, которые могут быть использованы для решения широкого класса задач:

от контекстного поиска документов с учетом всех словоформ, синонимов и опечаток

до создания систем поддержки принятия экспертных решений на основе анализа информационных

массивов.

RCO for Oracle, RCO for BackOffice, RC WEB и т.д. поисковые машины, инструментарии разработчика и аналитика.

RCO for Oracle ‑ единственный на рынке продукт, позволяющий значительно расширить возможности OracleText при работе c базами данных, содержащими документы на русском языке. RCO for Oracle задействует такие технологии, как лексико-грамматический и статистический анализ текста, алгоритмы автоматической классификации, рубрицирования и реферирования; нечеткого поиска, реализуя все существующие возможности OracleText для русского языка.

RCO for BackOffice Продукт позволяет расширить возможности

Microsoft BackOffice (MS SharePoint Portal, MS Indexing Service, MS Exchange

Server и MS SQL Server) при работе с документами на русском языке, обеспечивая

поиск с учетом всех грамматических форм слов на основе морфологического

анализа.

RC WEB![]() Продукт представляет поисковую систему,

обладающую возможностями как контекстного, так и реляционного поиска. Russian

Context позволяет искать документы с учетом морфологии русского и английского

языков, используя SQL-подобный язык запросов и комбинируя поисковые ограничения

на контекст с ограничениями на заданные атрибуты документов. Продукт работает в

среде Windows.

Продукт представляет поисковую систему,

обладающую возможностями как контекстного, так и реляционного поиска. Russian

Context позволяет искать документы с учетом морфологии русского и английского

языков, используя SQL-подобный язык запросов и комбинируя поисковые ограничения

на контекст с ограничениями на заданные атрибуты документов. Продукт работает в

среде Windows.

Инструментарий разработчика

RCO Morphology. Продукт позволяет включить

русскую морфологию в системы информационного поиска. RCO Morphology

поддерживает все возможности морфологического анализа для известных и

неизвестных слов русского языка: определение грамматических характеристик

слова, приведение к нормальной форме, получение требуемых словоформ. Продукт

поставляется в виде динамической библиотеки (dll) для Windows.

RCO

Thesaurus Search Продукт позволяет включить тезаурус русского языка в информационно-поисковые

системы для повышения полноты поиска. Тезаурус общей лексики содержит более 75 тысяч

слов и словосочетаний, связанных отношениями синонимии и общее-частное, а также

словарь семантически малозначимой лексики (стоп-слова). Продукт предназначен

для расширения запросов к тексту близкими по смыслу словами, а также для

отождествления близких по смыслу цепок слов и их приведения к единому виду.

Продукт

поставляется в виде динамической библиотеки (dll) для Windows.

RCO

Syntactic Engine Продукт позволяет включить возможности синтактико-семантического анализа

русского текста в интеллектуальные информационные системы, требующие работы со

смыслом документа. RCO Syntactic Engine позволяет решать задачи, требующие

выявления скрытых взаимосвязей между целевыми объектами (персоналиями,

организациями, событиями) и семантической классификации отношений между ними на

основе автоматического анализа текста.

Продукт

поставляется в виде динамической библиотеки (dll) для Windows.

![]()

RCO Semantic Network . Продукт предназначен для разработчиков

информационно-поисковых и аналитических систем и позволяет выявить ключевые

понятия документа, в том числе наименования персон и организаций, с

ассоциативными связями между ними на основе грамматического и статистического

анализа текста, а также получить несколько видов рефератов документа. Область

применения RCO Semantic Network охватывает задачи построения информационного

портрета документа, тематического индексирования полнотекстовых баз данных,

сбора информации о целевых объектах (персонах и организациях).

Продукт поставляется в виде динамической библиотеки (dll) для Windows и разделяемой библиотеки (shared library) для Linux.

RCO Pattern

Extractor Продукт предназначен для анализа текста и

распознавания в нем различных объектов в соответствии с образцами, заданными на

формальном языке. Область применения RCO Pattern Extractor в первую очередь

включает в себя выделение сложных элементов текста и специальных конструкций,

отличающихся особого вида написанием, – различных наименований, адресов,

номеров и т.п.

Продукт поставляется в виде динамической библиотеки (dll) для Windows.

В комплект поставки продукта входит стандартный набор образцов для выделения нескольких

классов объектов - наименований физических и юридических лиц, дат, составных

географических названий и ряда других объектов. Пользователю предоставляются

возможности настройки стандартных образцов и введения своих собственных,

описывающих интересующие объекты.

RCO TopTree

Продукт предназначен для автоматической

классификации и построения иерархических рубрикаторов по заданному множеству

произвольных объектов, характеризуемых набором атрибутов. Как объекты, так и их

атрибуты при анализе представляются целочисленными идентификаторами, поэтому их

семантика не имеет значения для работы библиотеки.

В сочетании со средствами автоматического анализа текста, позволяющими выделять

семантические атрибуты, продукт может использоваться при решении задач экспресс-анализа

и автоматической маршрутизации потоков документов.

Продукт поставляется в

виде динамической библиотеки (dll) для Windows.

![]() Инструментарий аналитика

Инструментарий аналитика

RCO КАОТ . Информационно-аналитическая система для

работы в локальной сети на базе MS Windows и MS Internet Information Server,

которая реализует комплекс функций интеллектуального анализа и поиска текстовой

информации с поддержкой Web-интерфейса пользователя.

Продукт представляет базовое решение для организации автоматизированного

рабочего места аналитика и включает в себя передовые технологии обработки

текста, лингвистические и математические алгоритмы. Эти средства могут быть

использованы для решения широкого класса задач: от контекстного поиска

документов с учетом всех словоформ, синонимов и опечаток до поддержки принятия

экспертных решений на основе анализа информационных массивов с применением

искусственного интеллекта.

В состав RCO

КАОТ входит набор программных модулей, часть из которых может поставляться или

адаптироваться к нуждам заказчика независимо от других.

RCO Fact

Extractor – это

персональное приложение для Windows, которое предназначено для аналитической

обработки текста на русском языке и выявления фактов различного типа, связанных

с заданными объектами – персонами и организациями. Основная сфера применения

программы – это задачи из области компьютерной разведки, требующие

высокоточного поиска информации, например, автоматический подбор материала к

досье на целевой объект или же мониторинг определенных сторон его активности,

освещаемых в СМИ. Программа позволяет не только найти фрагменты текста, в

которых говорилось, например, о поездках персоны, ее встречах, заключении

договоров, сделках купли-продажи, но и точно определить все места поездок,

визави и контрагентов, наименование товаров и прочее.

Столь полное перечисление

продуктов Oracle дано с целью возможного использования отдельных компонент для обработки

русских (и английских) текстов.

Наиболее интересна последняя программа - Fact Extractor, воплотившая в себе наиболее продвинутые решения из области компьютерной лингвистики и искусственного интеллекта, разработанные в компании “Гарант-Парк-Интернет”[2].

Программа работает в среде Windows 2000 и выше и позволяет обрабатывать документы в популярных текстовых форматах из различных источников - файловой системы, заданных web-сайтов, базы данных.

Результат работы программы – таблица, которая содержит информацию о найденных фактах, связанных с объектами мониторинга, и может экспортироваться в html-формат для формирования отчета или для загрузки в стороннее приложение, работающее с уже структурированными данными.

Fact Extractor предполагает настройку шаблонов для поиска и классификации фактов самых различных типов. Такие специализированные шаблоны либо приобретаются отдельно, либо создаются пользователем самостоятельно при помощи дополнительной программы Fact Tuner. Тем не менее, даже стандартные шаблоны, включенные в комплект поставки Fact Extractor, позволяют распознавать огромное количество самых разнообразных фактов, но без детальной классификации, т.е., попросту находить события, в которых участвует целевой объект, и извлекать из текста всех прочих фигурантов этих событий, без детализации их ролей.

С учетом уникальных механизмов выделения и отождествления различных обозначений объектов в тексте, даже эти стандартные возможности делают Fact Extractor весьма полезным поисковым инструментом в тех случаях, когда поиск ведется по персонам и организациям. Помимо собственно программы с графическим интерфейсом для Windows, компания “Гарант-Парк-Интернет” выпускает пакет для разработки программного обеспечения (SDK), на базе которого построен Fact Extractor и который позволяет включать возможности анализа текста в собственные приложения.

3.2. Продукты Convera

ООО «Convera» - российская компания, представляющая в

России и странах СНГ интересы американской корпорации Convera Technologies

International (ранее Excalibur). Семейство продуктов фирмы Excalibur Technologies

(США) - лидер архивных систем 3 и 4 поколений. Ее продукты в течение

использовались Госдепартаментом и Национальной библиотекой Конгресса США

(крупнейшее в мире электронное хранилище), ЦРУ, компаниями Ford Motors,

Lockheed, Reynold Electrical&Engineering, Maine Yankee Atomic Power, а в

России — ФАПСИ РФ, Конституционным

судом РФ, ВНИИ ГПЭ и рядом ведущих российских банков [3].

Такой широкий спектр разнообразных внедрений во многом определяется как уникальным механизмом нечеткого поиска, так и широкими возможностями создания собственных приложений, основанных на базовой технологии. Основу математического описания поискового механизма составляет так называемая нейронная сеть, позволяющая выделять в зашумленной битовой последовательности похожие фрагменты, не требуя точного контекстного совпадения запроса и фрагмента в документе.

Поиск ведется с привлечением семантической сети, ориентированной на использование лингвистических ресурсов языка. Для русского языка выделено два сильно связанных компонента.

Во-первых, это модуль морфологического анализа, преобразующий слова к их нормальным формам (для существительных — именительный падеж единственного числа, для глаголов неопределенная форма и т. п.). Фактически при этом задаются слова языка с различными вариантами написания и перечнем смысловых значений.

Во-вторых — тезаурус (словарь), устанавливающий связи между различными значениями слов с указанием типа и силы связи.

|

Уровни семантического расширения слов |

«Сила связи» |

Пример |

|

Слово-оригинал |

1.00 |

Легкий |

|

Точно совпадающие слова и морфологические варианты |

1.00 |

Легкий, легкие, легок |

|

Варианты написаний и неправильные формы слов |

0.84 |

Легкий |

|

Производные слова |

0.74 |

Легкость, облегчение, полегчать |

|

Строгие синонимы |

0.62 |

Элементарный, простой, нехитрый |

|

Синонимы |

0.55 |

Невесомый, пустяковый, эфемерный |

|

Строгие антонимы |

0.43 |

Тяжелый, увесистый, трудный, хитрый |

|

Антонимы |

0.27 |

Нетривиальный, непростой |

|

Связанные слова |

0.16 |

Весы, сложность |

|

Контрастные слова |

0.06 |

Нелегкий |

Был создан электронный тезаурус

(словарь) русского языка для более 40 тыс. общеупотребимых слов с необходимыми

связями. Теперь понятия «шли» и «идти» не стоят далеко друг от друга,

упорядоченные по алфавиту, а связаны как близкие, и по ним возможен нормальный

поиск. Разработаны и инструментальные средства для пополнения и дальнейшего

развития тезауруса. Convera

расширяет и развивает решения, заложенные в Excalibur [4].

В числе отличительных

особенностей решений Convera:

- возможность находить нужную информацию с помощью

«нечеткого» и ассоциативного поиска (используются технологии адаптивного

распознавания образов и представления предметной области в виде связанной

семантической сети);

- функции кросс-языкового поиска и динамической рубрикации

всей поступающей информации;

- высокая степень масштабируемости, обеспечивающая

аналитическую обработку десятков терабайт информации в

территориально-распределенной среде.

Создавая единое поисковое

пространство для организации с предоставлением богатого инструментария по

развитию системы, продукты Convera могут быть использованы для решения целого

ряда смежных задач. Например, в качестве программной платформы для проведения

конкурентной разведки, мониторинга СМИ и оценки маркетинговой активности

компании, проведения фоновой оценки компетенций персонала и пр.

Обеспечивая поиск, извлечение и

анализ огромных массивов как неструктурированных, так и формализованных данных,

решения Convera создают мощную и надежную платформу для построения корпоративной

системы управления знаниями. Продукты Convera «работают» не только с текстовой,

но и с мультимедийной информацией (видео, звук, графика и пр.), представленной

более чем в 250 форматах. Они позволяют осуществлять поиск данных по всему

многообразию корпоративных и внешних источников: в файловых системах, СУБД,

корпоративных почтовых и информационных системах, системах электронного документооборота,

а также в удаленных хранилищах данных, сети Интернет и пр.

3.3. Система ConExT

ConExt – система автоматизированного извлечения знаний из

текстов на естественном языке.

Компания «НооЛаб», Новосибирск, Россия [5], [6].

ConExT - система автоматизированного извлечения

знаний из текстов на естественном языке. Целью создания системы является

решение следующей задачи: помочь пользователю в получении знаний из больших

массивов текстовых документов без необходимости прочитывать их все.

При

подаче на вход текстов на естественном языке (в стиле "деловая

проза"), система способна реконструировать содержание и выделить имеющиеся

в тексте знания, которые могут быть представлены пользователю в виде компактных

отчетов (схем, рефератов), или направлены в базу знаний.

Новацией

предложенной и экспериментально проверенной модели является метод выделения из

текста содержательно-значащих единиц, их отвлечения от грамматической формы и

перехода к моделям содержания. Метод реализуется за счет взгляда на текст через

призму модельных представлений двух типов:

А) правила, традиции и

феномены выражения мыслей в текстах на русском языке;

Б) инвариантный к

языку ограниченный набор категорий, использующихся

при выражении подавляющего большинства знаний о мире (объектах, субъектах,

процессах, явлениях, отношениях и т.п.).

Важной

составляющей системы является язык программирования tExp, специально созданный

для решения задач структурного анализа неформализованных текстов на

естественном языке. Наличие языка программирования tExp позволяет гибко подстраивать

систему под особенности выражения содержания в различных прикладных областях.

Ядро ConExT включает в себя:

- декларативный язык

программирования высокого уровня tExp,

специально предназначенный для

создания программ синтаксической и семантической обработки текстов на

естественном языке;

- словарь русского языка Ru-Dict (на основе

синтаксического словаря Зализняка);

- прикладные программы синтаксического

анализа текста и перевода его в нормативные

лингвистические Е5-структуры;

- прикладные программы категориального

анализа, реконструирующие содержание -

объекты, описанные в тексте;

- принципы и методики спецификации прикладных

программ под конкретные приложения.

Итогом

лингвистического анализа является перевод простых предложений (и др.

лингвистических единиц) в единую "каноническую" форму Е-5 структуры.

Е-5 структура содержит в себе пять элементов (тематические объект и предикат,

связка, рематические объект и предикат) и играет роль обобщенной пропозициональной

модели.

Для

каждой лингвистической единицы строятся модели возможных объектов содержания.

Синтез отдельных объектов в единую систему осуществляется за счет

конструктивных моделей, таких, например, как "акт коммуникации",

"досье субъекта рынка", "отраслевая цепочка",

"событие", "технология публичной политики", "передел

собственности" и др.

Системы знаний:

знаниями считаются

структуры связанных между собой знаковой формы и объективного содержания; под

знаковой формой понимаются тексты или фрагменты текстов (упорядоченные по дате,

источнику, автору), а под содержанием - модели объектов, описанных в тексте

(компании, персоны, связи между ними, события и др.) и характеристики ракурса,

с которого автор текста описывает объекты.

Переработка текстов в данные и знания может быть специфицирована запросами пользователя:

- за счет введения запроса в виде ключевых слов или развернутого текста на естественном языке;

-

за счет

настроек - подключения специализированных словарей, категориальных и

понятийных шаблонов, являющихся

компонентами CONEXT

Главные

функциональные элементы CONEXT.

1. Предсинтаксический анализ текста

2. Выделение и анализ метатекста

3.

Извлечение из текста данных с помощью простых шаблонов

4. Выделение основных лексических единиц: простых предложений, причастных и деепричастных оборотов.

5.

Факторизация предложения

6. Определение синтаксического типа предложения

7. Синтаксический Е5-анализ

предложений

8. Дефакторизация предложения (развертывание предложения в его исходный

целостный сложный вид )

9. Определение групп подлежащего и сказуемого

10.

Анализ модального содержания

11.

Категориальный анализ

12.

Анализ коммуникативного содержания

13.

Понятийный синтез и извлечение из текста знаний

14.

Отличие от аналогов - принцип диспараллелизма формы и содержания, реализованный в CONEXT.

Ближайшим аналогом CONEXT является технология RCO компании Гарант-Парк-Метрикс. На основе открытой информации можно

заключить, что в RCO реализуется традиционный для формальной логики и семиотики принцип параллелизма формы и содержания

знаний.

Принцип параллелизма был подвергнут фундаментальной критике в работах по

основаниям логики (Г.П.Щедровицкий, Н.Г.Алексеев).

При реконструкции сложного системного содержания (например "передел

собственности", "отраслевая цепочка стоимости" и т.п.) можно

ожидать, что ограничения, накладываемые этим подходом, станут принципиальными.

В CONEXT реализована идея диспараллелизма, лежащая в основе содержательно-генетической

логики (Г.П.Щедровицикий,

Н.Г.Алексеев, И.С.Ладенко). Это является принципиальным

"ноу-хау" технологии, открывающим широкие возможности для

восстановления по рассеянной текстовой информации реальных сложных системных

объектов.

15. tExp - модели и алгоритмы CONEXT реализованы на специально созданном языке программирования tExp

ВОЗМОЖНОЕ ИСПОЛЬЗОВАНИЕ ConExT

Текст - базы данных

(T2DB)

До

недавнего времени информационные технологии "добычи данных" (data

mining) позволяли автоматически заполнять базы данных только числовой, или

специально формализованной и стандартизированной текстовой информацией.

ConExT создает принципиально новую возможность -

автоматически заполнять БД информацией из неформализованных текстов на

естественном языке. Предполагается использовать мощные и отработанные

технологии различных СУБД в новой области - для поиска и аналитической обработки

больших массивов текстов (анкет, новостей, аналитических обзоров, объявлений,

материалов из СМИ и т.д.).

ConExT позволяет обрабатывать тексты жанра деловой

прозы, извлеченные пользователем из интернета/интранета или любых других

хранилищ информации. Технология обеспечивает автоматическое выделение из

текстов простых сведений об объектах, таких как

·

товары и цены,

·

компании и их

атрибуты, адрес, телефон, электронная почта и т.д.

·

персоны, их

должности, адресе и т.д.,

·

географические

названия,

·

даты и

временные характеристики событий,

Выделенные сведения

заносятся в базы данных.

ЕЯ интерфейс: запросы

на естественном языке к базам данных

ConExT позволяет создать удобный для непрофессионального

пользователя интерфейс между человеком и базой данных. Человек вводит запросы в

произвольной форме на естественном языке, а ConExT автоматически

"понимает" содержание запроса и переводит его в формальный запрос к

базе данных.

Примеры запросов:

·

Есть ли

мобильники Sony дешевле $200?

·

Книги, журналы,

изданные позже

·

Что сказал

господин Иванов про господина Петрова в интервью?

·

Кто упомянут в

последних новостях в связи с выборами мэра города?

Эта функция ConExT

может найти применение во всех случаях, когда человеку нужно сделать запрос по

смыслу дела, и легче всего выразить этот смысл в обычной речевой фразе.

С

помощью ConExT электронный магазин сможет предоставить клиентам уникальный

сервис. Покупатель может запрашивать информацию в произвольной форме, по смыслу

дела, и при этом поиск товаров будет эффективным - легким, удобным и точным.

Пояснение на

примере торговли книгами.

Зачастую покупатель не помнит имени автора, точного названия книги, но достаточно хорошо представляет себе, какое именно содержание его интересует. Если бы у покупателя была возможность посоветоваться с консультантом-библиографом, он, несомненно, нашел бы нужную книгу и сделал покупку. Дело в том, что консультант знает книги не только по их названиям, но и по их содержанию, хотя бы на уровне аннотаций.

ConExT позволяет заместить человека-консультанта

интеллектуальной компьютерной технологией. За счет обработки аннотации с

помощью ConExT, для каждой книги может быть сформирована своя модель

содержания книги. Эти модели хранятся в БД, связанной с каталогом. Поиск

является эффективным потому, что запрос пользователя соотносится с

содержательными характеристиками книг.

Создатели ConExT описывают направление перспективных разработок, связывая

его с новым типом систем аналитики и информационной разведки.

Постановка проблемы

Часто

для принятия решения деловому человеку, финансисту или политику нужно иметь

точное знание о некоторой ситуации: вокруг каких ресурсов идет борьба? кто

участники? как между собой они связаны? как начнут развертываться события во

времени?

Но

если исходных сведений недостаточно, необходима исчерпывающая информация.

Обычно информацию собирают из дополняющих друг друга источников: от друзей, из

прессы, из телевизионных передач: Важнейший информационный канал - Интернет.

Профессиональная работа современного делового человека немыслима без

использования ресурсов электронной сети. В Интернете собираются сведения из печатных

изданий, независимых аналитических центров, информационных агентств. Эта

информация накапливается в информационных узлах - крупных порталах.

Безусловно,

Интернет - уникальное хранилище информации. Однако реальность такова, что

каждый из источников высвечивает только некоторую часть ситуации и с некоторой

частной точки зрения. Информация о единой ситуации оказывается рассыпана и

трудно интегрируемой. Мало того, что нужная информация разрозненна, рассредоточена

в массе различных текстов. Она еще и зашумлена тысячами других сведений.

Обычно

аналитику приходится проделывать большую и тяжелую работу. С помощью поисковых

систем "Яндекс", "Рамблер" и др. раскапывать документы.

Вручную отсеивать "мусор" - похожие, но не относящиеся к делу тексты.

Выискивать нужные сведения и приводить их в систему, чтобы уяснить целостную

картину события. Это стоит многих времени и сил. При этом важные косвенные и

неявные связи, слабые сигналы развития событий при подобной технологии зачастую

просто недоступны и остаются "невидимыми".

НооЛаб

предлагает переход от информационных к технологиям знаний, при этом важнейшим

элементом технологий знаний должны стать механизмы реконструкции содержания

текстов (ConExT). Примером реализации нового подхода является программный

комплекс РАСПАС, инициативную разработку которого компания НооЛаб ведет с осени

РАСПАС

должен стать принципиально новым инструментом информационной разведки и

аналитики, знаниевого оснащение управленческих мышления и деятельности.

В

отличие от, скажем, "Яндекса", в РАСПАС предполагается осуществлять

поиск документов не по ключевым словам, а по содержанию. РАСПАС должен

реконструировать содержание текстов - кто? с кем? по поводу чего? когда? где?

При этом по многим различным документам в базе знаний должна воссоздаваться

единая структурная модель ситуации.

Используя РАСПАС, предполагается получать:

·

сведения о

полном составе участников и действующих лиц ситуации;

·

тексты их

высказываний о ситуации и друг о друге;

·

сведения о их

связях, характере действий, целях и т.д.;

·

знания о

временной динамике происходящих событий;

·

знания об

источниках, освещающих событие.

РАСПАС должен обеспечивать непрерывное информационное

отслеживание ситуации, построение прогнозов развития событий и их фактическую

проверку.

3.4. OntosMiner

Набор продуктов Ontos Series, разработан швейцарской компанией Ontos AG при активном участии российских ученых. Продукты Ontos решают две основные задачи: получение информации из различных гетерогенных источников (базы данных, Internet, поисковые машины, файловые серверы и т. д.) и ее последующая обработка с использованием оригинальных лингвистических алгоритмов [7].

Ontos позволяет не только взаимодействовать с файлами и базами данных различных форматов, но и обрабатывать содержимое документов с учетом их форматирования. В частности в документе различается основной текст, заголовки разделов, таблицы и т. д. Однако главной изюминкой продуктов Ontos является инновационный механизм OntosMiner* аналитической обработки текстов, основу которого составляет патентованная технология, относящаяся к классу NLP (Natural Language Processing -- обработка естественного языка).

OntosMiner разработан на основе продукта GATE (General Architecture

for Text Engineering),

который представляет собой SDK, распространяемый бесплатно по лицензии GNU

(Open Source) Шеффилдским университетом (Великобритания).

В отличие от

классической схемы обработка документов в OntosMiner изначально

осуществляется с учетом конкретной предметной области и возможных вариантов

анализа исходных материалов, что приводит к резкому сокращению анализируемых

комбинаций слов. При этом теряется

универсальность, однако опыт практического применения полнотекстовых баз данных

показывает, что основной объем информационных задач связан с выполнением

запросов вполне конкретного вида (в конце концов, режимы полнотекстового поиска

всегда можно применить к любым документам).

Второе важное новшество заключается в том, что между различными словами-существительными выявляются взаимосвязи качественно более высокого уровня, которые обычно описываются глагольными формами (иллюстрируется на примере). Как известно, при решении нечетких математических задач встречаются ошибки 1-го (обнаружение ложной цели) и 2-го (пропуск реальной цели) рода. Подобные ситуации возникают и при обработке текстов, простейший случай - выборка документов, не относящихся к теме запроса, или пропуск нужных документов.

При решении этой проблемы в NPL-технологии используется известный медицинский принцип "не навреди". В данном случае ошибки 1-го рода исключаются за счет того, что фрагменты текстов, не поддающиеся смысловой обработке, просто игнорируются. Конечно, такой подход резко повышает вероятность появления ошибки 2-го рода. Но тут следует учесть, что автоматическая обработка подразумевает анализ не одного, а сотен и тысяч документов.

Теория вероятности убедительно

показывает, что если в одном документе вероятность пропуска цели составляет

50%, то при комплексной обработке уже 10 документов она снижается до 0,1% (т.

е. в каждой из 10 попыток проверки гипотезы будет допущена ошибка).

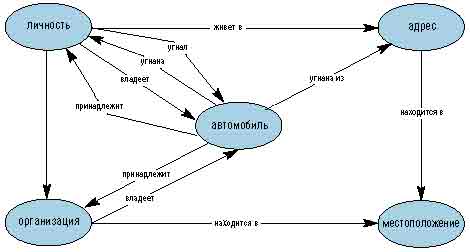

Система использовалась в частности для анализа рапортов в предметной области "Угон автомобиля". В результате обработки формируется структурированный XML-образ документа, который может отображаться в виде сетевой диаграммы Cognitive Map (когнитивные карты) типа приведенной ниже.

Имея такие формализованные модели, можно

достаточно просто выполнять самые различные запросы, определяя, например,

наиболее криминальные районы, самые любимые преступниками модели машин или

выявляя сложные взаимосвязи между разными персонами (для формирования подобных

запросов используются специальные графические инструменты).

Формирование словарей Ontology

В приведенном примере, использовались

документы определенного вида, хотя и заполненные в относительно произвольной

форме. На самом же деле в качестве исходных могут выступать самые различные

материалы.

Состав и структура извлекаемых данных все равно определяются конкретными словарями типа Ontology, которые являются специфическими для каждой предметной области (точнее, класса решаемых аналитических задач) и сильно зависят от национальных особенностей языка.

Для получения их пользователю предлагается три основных варианта. Первый - использовать готовые "вертикальные" решения. Они формируются разработчиками (специалистами компании Ontos и ее партнеров) для наиболее широких сегментов рынка. На сайте www.ontosearch.com уже есть целый набор словарей для различных сфер деятельности - политика, медицина, финансы, правда, в большинстве своем для английского и немецкого языков (словари поставляются в виде платного сервиса).

Второй вариант - заказать создание таких словарей для конкретных целей (именно так был реализован проект в МВД Киргизии). Третий - формировать их собственными силами.

В составе продуктов Ontos Series имеется также набор инструментов для создания и редактирования Ontology-словарей, в том числе с использованием простейших методов самообучения.

3.5. Язык OWL

3.5.1. Общие сведения

Проблему представления знаний (knowledge representation) в настоящее время

обычно именуют онтологией. Эта проблема интенсивно разрабатывается создателями Internet-стандартов, на переднем крае разработок в этой

сфере сейчас находится Семантическая

Сеть (Semantic Web, согласно терминологии W3C). По словам Тима Бернерс-Ли, «основателя»

WWW, Семантическая Сеть — развитие концепции существующей глобальной сети. С

целью описания и представления объектов в Семантической Сети создается язык OWL (Ontology Web Language),

разработку которого одобрил консорциум W3C[8]. В настоящее время

разработчикам Семантической Сети стало

очевидно, что средств XML и RDF для представления информации и метаданных для

построения полноценной семантически связанной сети недостаточно.

По мнению разработчиков OWL, поможет запустить автоматизированные инструменты для глобальной сети нового поколения, предлагая такие усовершенствованные услуги, как более точный Web-поиск, интеллектуальные программные агенты и управление знаниями.

Согласно принципам Семантической Сети, процесс создания электронных документов разбивается на две части: создание собственно документа, содержащего некоторые термины, и создание его онтологии. Язык OWL записывает онтологию на некотором языке (с естественно-языковой ориентаций уровня SQL) и в формате XML. Однако в основе OWL находится LBase — исключительно математический язык, который опирается на аппарат математической логики и предикатов, и предназначен для машинных низкоуровневых логических выводов.

Разработчики OWL ссылаются на язык логического программирования Пролог для вывода из фактов,

находящихся в базе знаний программы, новых фактов, опираясь на логические

теоремы. По сути OWL базируется на одной из модификаций

представления знаний с помощью формул исчисления предикатов. Язык OWL включает ряд интересных особенностей (логический вывод,

развитые средства работы с онтологиями, в частности с их версиями; поддержку

теоретико-множественных операций; организацию иерархий как классов, так и

свойств), однако вопрос о преодолении в реализациях языка недостатков, присущих

внутренним механизмам Пролога, остается открытым.

3.5.2.

Веб-онтологии OWL

По языку OWL в Интернет имеется достаточно подробная и постоянно модифицируемая документация [9]. Приведем некоторые фрагменты из перевода на русский язык исходной английской версии [10], дающие некоторое представление о стиле использования языка.

Язык OWL - это язык для определения и представления веб-онтологий. Веб-отнология может включать описания классов, свойств и их примеры. Формальная семантика OWL описывает, как получить логические следствия, имея такую онтологию, т.е. получить факты, которые не представлены в онтологии буквально, но следуют из ее семантики. Эти следствия могут быть основаны на одном документе или множестве распределенных документов, которые комбинируются с использованием определенных механизмов OWL.

Вопрос, который возникает, когда описываешь еще один

XML/Web стандарт, - это "Что это дает,

чего не могут дать XML и XML Schema?" Есть два ответа на этот вопрос.

- Онтология отличается от схемы XML тем, что это

представление знания, а не формат сообщений. Большинство веб-стандартов

состоят из комбинации форматов сообщений и спецификаций протоколов. Этим

форматам дали эксплуатационную семантику, типа, "По получении

сообщения ЗаказНаПокупку,

перевести Количество

рублей со СчетПокупателя

на СчетПродавца

и отпустить Товар."

Но спецификация не создана для поддержки операций вне контекста данной транзакции.

Например, у нас нет, как правило, механизма, чтобы заключить, что из-за

того, что Товар

имеет название Шардоне, он должен также быть белым вином.

- Одним из преимуществ OWL онтологий будет

доступность инструментов, которые могут рассуждать о них. Инструменты

обеспечат общую поддержку, которая не является специфической для

данной предметной области, что было бы тем случаем, когда надо построить

систему, чтобы рассуждать в пределах одной стандартной для данной

индустрии XML схеме. Построение четкой и работоспособной системы

рассуждения - непростое дело. Строительство онтологии намного более

доступно. Мы ожиданием, что много групп предпримут строительство

онтологий. Они извлекут выгоду из инструментов третьих лиц, основанных на

формальных свойствах языка OWL, инструментов, которые предоставят

ассортимент возможностей, которые большинству организаций было бы трудно

реализовать самим.

OWL обеспечивает три различных по выразительности диалекта,

спроектированных для использования отдельными сообществами разработчиков и

пользователей.

·

OWL Lite поддерживает тех пользователей, которые нуждаются, прежде всего,

в классификационной иерархии и простых ограничениях. Например, притом, что он

поддерживает ограничения кардинальности (количества элементов), допускаются

значения кардинальности только 0 или 1. Для разработчиков должно быть проще в

своих продуктах обеспечить поддержку OWL Lite, чем его более выразительных

собратьев, в частности, OWL Lite позволяет быструю миграцию тезаурусов и других

таксономий.

·

OWL DL поддерживает тех пользователей, которые хотят максимальной

выразительности без потери полноты вычислений (все заключения гарантировано

будут вычисляемыми), и разрешаемости рассудочных систем (все вычисления

завершатся в определенное время). OWL DL включает все языковые конструкции OWL

с ограничениями вроде разделения типа (класс не может быть частным свойством, а

свойство не может быть индивидом или классом). OWL DL так назван из-за его

соответствия дескриптивной логике [Дескриптивная

логика], дисциплине, в которой изучен именно разрешаемый фрагмент логики

первого порядка. OWL DL была спроектирована, чтобы поддержать существующий

сегмент бизнеса, занимающийся дескриптивной логикой, и иметь желательные вычислительные

свойства для систем рассуждения.

·

OWL Full предназначается для пользователей, которые хотят

максимальную выразительность и синтаксическую свободу RDF без вычислительных

гарантий. Например, в OWL Full класс может одновременно рассматриваться и как

совокупность индивидов, и с равным правом как индивид. Другое существенное отличие

от OWL DL в том, что owl:DatatypeProperty может

быть помечено как owl:InverseFunctionalProperty.

OWL Full позволяет такие онтологии, которые расширяют состав предопределенного

(RDF или OWL) словаря. Маловероятно, что какое-либо рассудочное программное

обеспечение будет в состоянии поддержать полную поддержку каждой особенности

OWL Full.

Каждый из этих диалектов - расширение его более простого

предшественника, и в том, что касается выразительных возможностей, и в том, что

касается возможностей производимых заключений. Поддерживаются следующие

отношения, но не наоборот.

- Каждая допустимая OWL Lite онтология - допустимая

OWL DL онтология.

- Каждая допустимая OWL DL онтология - допустимая OWL

Full онтология.

- Каждое правильное OWL Lite заключение - правильное

OWL DL заключение.

- Каждое правильное OWL DL заключение - правильное

OWL Full заключение.

Разработчики онтологий, использующие OWL, должны решить,

какой из диалектов лучше подходит к их задачам. Выбор между OWL Lite и OWL DL зависит

от степени того, насколько пользователям требуются более выразительные

конструкции, обеспечиваемые OWL DL. Приложения для OWL Lite будут иметь

желаемые вычислительные характеристики. Приложения для OWL DL, при том, что

имеют дело с разрешаемым диалектом, в самых тяжелых случаях будут связаны с

более высокой сложностью.

Выбор между OWL DL и OWL Full, главным образом, зависит от

степени того, насколько пользователям требуются средства мета-моделирования RDF

Схем (например, определяющие классы классов). При использовании OWL Full, по

сравнению с OWL DL, рассудочная поддержка менее предсказуема. Для дальнейшей

информации см. Семантика

OWL.

Пользователи, мигрирующие из RDF в OWL DL или OWL Lite

должны позаботиться о том, чтобы оригинальный RDF-документ выполнял

ограничения, наложенные OWL DL и OWL Lite. Детали этих ограничений объясняются

в Приложении

E Справки по OWL.

Когда мы представляем конструкции, которые разрешаются

только в OWL DL или OWL Full, они помечаются "[OWL DL]".

Нормативный синтаксис обмена OWL - RDF/XML. Заметьте, что

OWL был спроектирован с максимальной совместимостью с RDF и RDF Schema. Форматы

XML и RDF - часть стандарта OWL.

OWL предполагает открытость.

То есть, описания ресурсов не ограничены единственным файлом или темой. В то

время как класс C1 первоначально может быть

определен в онтологии O1, он может быть расширен в других онтологиях. Следствия

из этих дополнительных суждений о C1

являются монотонными. Новая информация не может опровергать предыдущую

информацию. Новая информация может быть противоречащей, но факты и следствия

могут только добавляться, и не могут удаляться.

Типичная OWL онтология начинается с объявления пространства

имен (namespace),

Способность OWL выражать онтологическую информацию об

индивидах, содержащихся во множестве документов, принципиальным образом

поддерживает связывание данных из разных источников. Лежащая в основе семантика

обеспечивает возможность делать выводы из этих данных, что может привести к

неожиданным результатам. В частности способность выражать эквивалентность с

помощью owl:sameAs может быть

использована, чтобы заявить, что как будто бы различные индивиды на самом деле

одно и то же. Owl:InverseFunctionalProperty

также может быть использовано, чтобы связать индивидов вместе.

Например, если такое свойство как "ИНН" является owl:InverseFunctionalProperty, то два отдельных человека могли бы быть расценены как

один и тот же на основе того, что они имеют одно и то же значение этого

свойства. Когда идентичность индивидов определяется такими средствами,

информация о них из разных источников может быть слита. Эта агрегация

может использоваться, чтобы определить факты, которые не представлены прямо

ни в одном из источников.

Способность Семантической Сети связывать информацию из

многих источников - желательное и мощное свойство, которое может использоваться

во многих приложениях.

Однако, способность объединять данные из многих источников в сочетании с мощью

логического вывода OWL, действительно имеет потенциал для злоупотребления.

Пользователи OWL должны быть заботиться о потенциальной угрозе секретности.

Детальные решения по защите информации были расценены как выходящие за область

рассмотрения данной рабочей группой. Множество организаций, занимающихся этими

вопросами, предлагает широкий спектр решений по безопасности и секретности.

Наиболее фундаментальные понятия в какой-то области должны

соответствовать классам, которые находятся в корне различных таксономических

деревьев. Каждый индивид в мире OWL является членом класса owl:Thing. Таким образом каждый определенный пользователем класс

автоматически является подклассом owl:Thing. Специфичные для данной области корневые классы

определяются простым объявлением именованного класса. OWL также определяет

пустой класс, owl:Nothing.

Фундаментальным таксономическим конструктором для классов

является rdfs:subClassOf. Он связывает

более частный класс с более общим классом. Если X - подкласс Y, то каждый

представитель X - также представитель Y. Отношение rdfs:subClassOf является транзитивным. Если X - подкласс Y, и Y - подкласс

Z, то X - подкласс Z.

Определение класса состоит из двух частей: указание названия или ссылка и список ограничений. Каждое из непосредственно содержащихся в определении класса выражений ограничивает (уточняет) свойства представителей определенного класса. Представители класса принадлежат к пересечению указанных ограничений.

В дополнение к классам мы хотим иметь возможность описать их

членов. Обычно мы думаем о них как об отдельных индивидах в нашем пространстве

вещей. Для определения индивида достаточно объявить его членом какого-то

класса.

Например:

<Регион rdf:ID="РегионЦентральногоПобережья" />

Есть пара моментов, на которых

здесь следует остановиться. Во-первых, мы решили, что РегионЦентральногоПобережья (определенная область) является членом Регион, класса, содержащего все географические регионы.

Во-вторых, нет никаких требований в примере из двух частей, что эти два элемента

должны следовать друг за другом, или даже находиться в одном и том же файле

(хотя, в противном случае их названия должны были бы быть расширены с помощью

URI). При проектировании веб-онтологий нужно помнить, что они предназначены для

распределенной среды. Они могут быть импортированы и расширены, создавая новые

производные онтологии.

Существуют проблемы относительно различия между классом

и индивидом в OWL. Класс - это просто название и совокупность свойств,

которые описывают набор индивидов. Индивиды - это члены этих наборов. Таким

образом, классы должны соответствовать естественно образованным наборам вещей в

рассматриваемой области, а индивиды должны соответствовать реальным объектам,

которые могут быть сгруппированы в эти классы.

При создании онтологий, это различие часто размывается в

двух направлениях:

- Уровни представления: В определенных

контекстах что-то, что очевидно является классом, может самостоятельно

считаться представителем чего-то еще. Например, в онтологии вина мы имеем

понятие Виноград,

которое призвано обозначать набор всех разновидностей винограда. ВиноградКабернеСовиньон

- пример представителя этого класса, поскольку он обозначает фактический

сорт винограда, называемого Каберне-Совиньон. Однако, ВиноградКабернеСовиньон

мог бы сам считаться классом, обозначающим набор всех реальных кустов винограда

Каберне-Совиньон.

- Подкласс или частный случай: Бывает очень

просто спутать отношения по типу представитель-класс с отношением по типу

подкласс-надкласс. Например, выбор сделать ВиноградКабернеСовиньон индивидом,

являющимся представителем класса Виноград, а не подклассом класса Виноград

может показаться чисто произвольным. Но это не произвольное решение. Класс

Виноград

обозначает набор всех сортов винограда, и поэтому любой подкласс Винограда

должен обозначать подмножество этих сортов. Таким образом,

ВиноградКабернеСовиньон должен считаться представителем

Винограда, и не подклассом. Ведь он не описывает подмножество сортов

винограда, он сам является сортом.

Свойства

позволяют нам утверждать общие факты о членах классов и особые факты об

индивидах. Свойство - это бинарное

отношение. Различают два типа свойств:

- свойства-значения, отношения между

представителями классов и RDF-литералами или типами данных, определяемых

XML Schema

- свойства-объекты,

отношения между представителями двух классов. Заметьте, что слово объект

в названии не связано с RDF-термином

Пример определения:

<owl:ObjectProperty rdf:ID="сделаноИзВинограда">

<rdfs:domain rdf:resource="#Вино"/>

<rdfs:range rdf:resource="#Виноград"/>

</owl:ObjectProperty>

В OWL последовательность элементов без явного указания оператора представляет собой неявное соединение. Свойство сделаноИзВинограда имеет домен Вино и диапазон Виноград. Таким образом, это связывает представителей класса Вино с представителями класса Виноград. Множественные домены означают, что доменом свойства служит пересечение указанных классов (и подобным образом для диапазона).

Использование информации о диапазоне и домене в OWL отличается от информации о типе данных в языках программирования. В частности, в языках программирования типы данных используются, чтобы отслеживать взаимоувязанность кода. В OWL диапазон значений может использоваться, чтобы наследовать тип.

Свойства, так же как классы, могут быть организованы в

иерархию.

Мы отличаем свойства по тому, связывают ли они индивидов с

индивидами (свойства-объекты) или индивидов с типами данных

(свойства-значения). Свойства-значения могут иметь диапазон литералов RDF или

простых типов, определенных в XML

Schema datatypes.

OWL использует большинство встроенных типов XML Schema.

Ссылки на эти типы осуществляются посредством URI для типов http://www.w3.org/2001/XMLSchema. В документации перечислены более 30 типов данных, рекомендуемых

для использования с OWL. Другие встроенные типы XML Schema могут использоваться

в OWL Full, но с предостережениями, описанными в документе Семантика

и абстрактный синтаксис OWL.

Картирование

онтологий

Для того, чтобы онтологии имели максимальный эффект, они

должны быть широко распространены. А чтобы минимизировать интеллектуальные

усилия, затрачиваемые на разработку онтологий, они должны быть пригодными для

многократного использования. В лучшем из всех возможных варианте они должны

быть составлены из компонентов. Например, Вы могли бы воспользоваться

онтологией даты из одного источника и онтологией физического местоположения из

другого, и затем расширить понятие местоположения, включив в него период

времени, в течение которого данное местоположение сохраняется.

Важно понять, что большая часть усилий по разработке онтологии

посвящена связыванию вместе классов и свойств так, чтобы максимально точно

передать заложенный в понятия смысл. Мы хотим, чтобы простые утверждения о

членстве в классе имели широкие и полезные последствия. Это - самая сложная

часть разработки онтологии. Если Вы можете найти существующую онтологию,

которая уже широко используется и хорошо проработана, то имеет смысл

приспособить ее для своих нужд.

Чтобы связать вместе ряд онтологий, входящих в качестве

компонентов в какую-то третью онтологию, часто полезно иметь возможность

указать, что данные класс или свойство в одной онтологии эквивалентны классу

или свойство во второй онтологии. Эта способность должна использоваться с

осторожностью. Если объединенные онтологии являются противоречащими (все А - это

Б, в другой все А - это не Б), то не будет никакого расширения (ни индивидов,

ни отношений), который удовлетворяли бы получающуюся комбинацию.

В OWL нет допущения об уникальном имени. То, что

два имени отличны друг от друга, не означает, что они обозначают различных

индивидов. Объявление идентичными двух индивидов выполняется с помощью sameAs, а для указания явного

различия - с помощью differentFrom.

Для формирования классов OWL обеспечивает дополнительные

конструкции. Эти конструкции могут использоваться для создания так называемых выражений

класса. OWL поддерживает основные операторы множеств, а именно объединение,

пересечение и дополнение. Они называются, соответственно, owl:unionOf, owl:intersectionOf и owl:complementOf. Дополнительно

классы могут быть перечисленными. Расширения класса могут быть

заявлены явно посредством конструктора oneOf. И можно утверждать, что расширения класса должны быть

непересекающимися.

OWL обеспечивает средства определения класса через прямое

перечисление его членов. Это делается с помощью конструкции oneOf.

Замечательно, что это определение полностью определяет диапазон класса, так,

что никакие другие индивиды не могут быть объявлены как принадлежащие к данному

классу.

Непересекаемость набора классов может быть выражена с

помощью конструкции owl:disjointWith. Это

гарантирует, что индивид, который является членом одного класса, не может

одновременно быть представителем обозначенного другого класса.

Онтологии,

подобно программному обеспечению, требуют технической поддержки и, таким образом,

изменяются со временем. В пределах элемента owl:Ontology можно указать ссылку на предыдущую версию онтологии. Для

обеспечения этой связи предназначено свойство owl:priorVersion, которое может использоваться, чтобы проследить историю

версий онтологии.

Версии

онтологий могут быть несовместимыми друг с другом. Например, предыдущая версия

онтологии может содержать утверждения, которые противоречат текущей версии. В

пределах элемента owl:Ontology, мы используем

тэги owl:backwardCompatibleWith и

owl:incompatibleWith, чтобы указать на совместимость или ее отсутствие с

предыдущими версиями данной онтологии. Если owl:backwardCompatibleWith не объявлен, то совместимость не должна предполагаться. Кроме

того, owl:versionInfo обеспечивает

средства, пригодные для использования системами отслеживания версий. В

противоположность предыдущим трем тэгам, типом данных owl:versionInfo является литерал, и этот тэг может использоваться, чтобы

аннотировать классы и свойства в дополнение к онтологиям.

OWL

Full обеспечивает экспрессивную мощь для того, чтобы сделать утверждения любого

вида о классе, то есть, что это он является представителем другого класса, или

что он (а не его представители) имеет свойство и значение для этого свойства.

Эта структура может использоваться, чтобы построить онтологию классов и свойств

для отслеживания информации о версиях. OWL namespace включает два предопределенных

класса, которые могут использоваться для этих целей: owl:DeprecatedClass и owl:DeprecatedProperty. Они предназначены для указания того, что класс или

свойство вероятно будут изменены несовместимым образом в предстоящем выпуске.

Важно отметить, что owl:DeprecatedClass и owl:DeprecatedProperty не имеют никакой дополнительной семантики, и то, что они

используются по предназначению - целиком на совести разработчиков и пользователей

OWL.

В дополнение к языкам онтологий, различные таксономии и

существующие онтологии уже находятся в коммерческом использовании. В сайтах

электронной коммерции они облегчают коммуникацию посредством компьютера между

покупателем и продавцом, делают возможной вертикальную интеграцию рынков и позволяют

описаниям многократно использоваться на различных рынках. Примеры сайтов,

которые фактически создают онтологии для коммерческого использования, можно

найти в Интернет.

Разработаны различные медицинские или фармацевтические

онтологии, чтобы помочь управлять огромной массой данных современных медицинских

и биохимических исследований, которые бывает трудно связать вместе в единое

целое. Один из главных ресурсов Консорциум

Генных Онтологий.

Сегодня находятся в использовании большие таксономии,

которое были бы готовы для внедрения в OWL-пространство. Например,

Североамериканская Система Классификации Промышленности (NAICS) определяет

иерархию из более чем 1900 элементов, которые идентифицируют типы

промышленности. NAICS также связана с Международной Системой Классификации

Индустриальных Стандартов (ISIC, Ревизия 3), разработанной и поддерживаемой

Организацией Объединенных Наций.

3.6. Медиалогия

Медиалогия on-line система анализа информации из открытых источников: газет, журналов, информационных агентств, интернет-ресурсов, радио и телевидения. Система ориентирована на задачи управления бизнесом и по-видимому использует комбинированный подход, используя как алгоритмы обработки текста, так и когнитивные методы [11].

Система ежедневно структурирует, оценивает и семантически обрабатывает десятки тысяч сообщений из центральных, региональных и специализированных русскоязычных изданий, а также материалы ведущей иностранной прессы. В числе решаемых в системе Медиалогия задач - конкурентный анализ, информационная разведка, управление репутацией, изучение отраслевого рынка, оперативный мониторинг, просмотр новостей после выхода в эфир и другие.

В основе методики системы лежит классический компьютерный

анализ текста, который базируется на представлении содержания документа в форме

семантической сети ключевых понятий, ассоциативно связанных между собой.

Семантическая сеть реализуется с помощью Java

Applet. В качестве основы для пользовательского интерфейса и для

клиентов-операторов используется платформа Microsoft.NET.

Архитектура базируется на

платформе Windows 2000 Server. В каждой подсистеме своя кластерная часть,

которая поддерживает работу сервера баз данных Microsoft SQL Server 2000 и

сервера приложений Internet Information Server. В системе «Медиалогия»

используется несколько специальных решений для обеспечения безопасности,

визуализации данных и для поиска информации. В качестве сервера приложения используется

Microsoft Information Server. Обмен данными между подсистемами осуществляется в

формате XML.

Полнотекстовое индексирование Microsoft SQL Server 2000 реализовано с использованием RCO Morphology – библиотеки морфологического анализа текста компании «Гарант Парк Интернет». RCO Morphology дополняет технологию полнотекстового поиска по массивам документов Microsoft full-text Search компонентами, отвечающими за учет морфологии русского языка при построении индексов и обработке поисковых запросов;

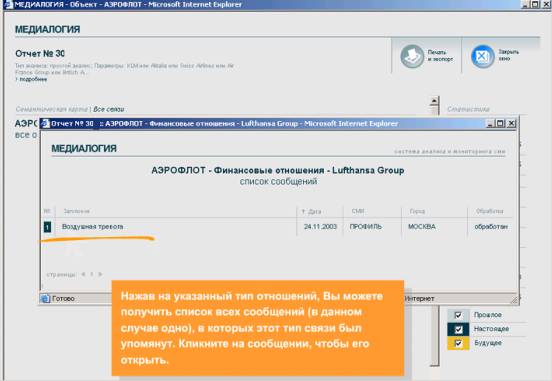

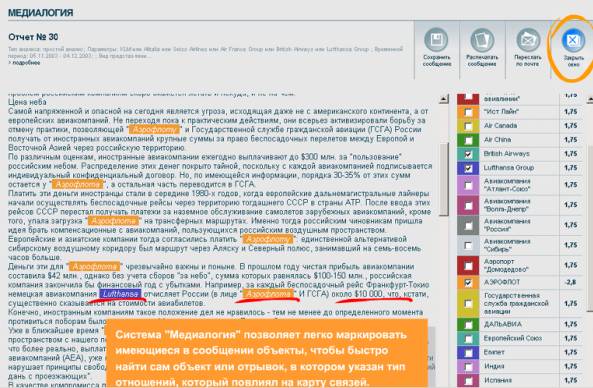

Стиль работы с системой

иллюстрируют фрагменты видеоролика, приведенные на рис. 1, 2 и 3. Выбрав ряд

параметров, аналогично выбору финансовых отношений Аэрофлота на рис.1,

пользователь получает фрагмент семантической сети (граф отношений) – рис. 2.

Выбрав далее узел по нужному отношению, пользователь получает отчет, в котором

интересующие его объекты маркированы – рис. 3.

Рис. 1. Ввод параметров для получения семантической карты.

Рис. 2. Семантическая карта.

Рис. 3. Отчет по выбранному узлу семантической карты.

3.7. Программа Starlight 3.0

Зарубежные проекты и системы декларирует учет при обработке текстов лингвистических атрибутов и глубинной семантики, однако для русского языка эти системы требуют существенной модификации. Для оценки уровня разработок приведем пример системы Starlight 3.0 (разработанной в лаборатории PNNL), взятой на вооружение Министерством внутренней безопасности США[12].

Эта новая программная система, предназначена для поиска в интернете свидетельств террористической деятельности. Система Starlight 3.0 была разработана Тихоокеанской северо-западной национальной лабораторией (PNNL) по заказу силового ведомства США.Она представляет собой аналитическое средство, извлекающее из обильного почтового и веб-трафика информацию о связях между людьми, населенными пунктами и событиями. Внедрение программа Starlight 3.0 предполагалось в сентябре 2005 года. На основе проанализированных данных она должна выстраивать наглядные графические связи между объектами, описанными в многочисленных текстовых документах, а также изображениях, аудио- и видеозаписях.

Отслеживанием сетевой активности, прослушиванием телефонных разговоров и анализом открытых и конфиденциальных финансовых транзакций федеральные правоохранительные органы США занимаются давно. Полученные силовиками данные заносятся в гигантские информационные хранилища. Но программа, которая использовалась федеральными службами до сих пор, не обеспечивала наглядной визуализации связей. Новый графический интерфейс Starlight 3.0 позволит проводить интерактивный анализ базы данных, отсеивать нерелевантную информацию и поможет эффективно интегрировать поступающие новые потоки данных в существующее хранилище.

Система Starlight 3.0 способна анализировать одновременно до 40000 документов, в то время как предыдущая версия программы обрабатывала лишь 10000 документов. Кроме того, Starlight 3.0 обеспечивает одновременную визуализацию нескольких аналитических процессов, в том числе работающих с геоинформационными источниками данных. Благодаря этому наблюдатель сможет как определить временные и пространственные характеристики нескольких событий, так и их связи с другими важными событиями. Starlight работает в среде Windows и использует формат XML.

В настоящее время в лаборатории PNNL ведутся работы по совершенствованию еще одной программы - IN-SPIRE. Она способна извлекать осмысленные знания из больших массивов данных (включая тексты на нескольких естественных языках). Аналитические средства этой программы позволяют проверять различные гипотезы с помощью построения сложных моделей. Аналогичные системы используют и другие ведомства, в частности в Министерстве обороны функционирует система IxReveal. Система извлекает знания из больших текстовых массивов и позволяет отвечать на сложные вопросы.

3.8. UIMA(IBM)

Системе UIMA, разработанной IBM, уделено относительно больше внимания в силу двух привлекательных факторов: открытые тексты (в настоящий момент на JAVA, в дальнейшем предполагается доступность на платформе C++ ) и достаточно подробная документация. Документация содержит как описание концепций системы, так и технику работы с программными интерфейсами (примеры построения анализаторов). К сожалению в текущей версии эти анализаторы существенно ориентированы на английский язык, а создание анализаторов для русского языка (даже при наличии исходных текстов аналогичных анализаторов для английского) - требует специальной научной компетенции.

3.8.1. Общие сведения

Практическое отсутствие документации по UIMA на русском языке затрудняет адекватный перевод терминов, поэтому далее часто будет даваться ссылка (обычно в круглых скобках) на термин в исходном документе[15]. Перевод в основном выполнялся по возможности ближе к тексту оригинала. В процессе анализа неструктурированного (текстового) содержания в UIMA используются различные технологии анализа, включающие:

- обработка естественного языка с использованием статистики и правил(шаблонов);

- извлечение информации (Information Retrieval - IR);

- машинное обучение (Machine learning);

- онтологии (Ontologies);

- автоматический вывод (Automated reasoning);

- источники знаний (Knowledge Sources - WordNet, FrameNet, etc.).

При

анализе используется термин “span”

(спан, кусок, фрагмент) для выделения сплошного отрезка текста, обозначающее

некоторое целостное понятие. Фрагмент характеризуется начальной и конечной позицией и указанием на понятие, которое он

обозначает. Например, фрагмент “Fred Centers” от позиции 101 до 112 в некотором документе может

обозначать организацию (в исходном тексте “лицо” - The span from position

101 to

Результаты анализа (в частности аннотаторы) организуются в так называемую Общую Аналитическую Структуру (Common Analysis Structure (CAS)), в дальнейшем обозначаемую CAS-структура или просто CAS. Эта объектно-ориентированная структура позволяет представить объекты, свойства и значения. UIMA допускает вхождение объекта более чем в одну иерархию. UIMA предоставляет возможность включать в CAS не только базовые типы, но и их произвольное расширение, описываемое в Системе Типов (Type System). В первом приближении можно считать, что Система Типов это схема объекта в СAS.

Система типов описывает объекты,

которые могут быть обнаружены в документах и

записаны в CAS. Типы

могут иметь свойства (properties or features),

например “Age” и “Occupation” могут описывать свойства типа “Person”. Примеры других возможных типов: организация, компания, банк, Ссуда, Деньги, Размер, Цена, Телефонный Номер, Обращение по

телефону, Отношение, Сетевой пакет, Изделие, Группа Существительного, Глагол,

Цвет, Узел парсинга(разбора), Массив весовых свойств (Organization, Company, Bank, Facility, Money, Size, Price, Phone Number, Phone Call, Relation, Network Packet, Product, Noun Phrase, Verb, Color, Parse Node, Feature Weight Array etc.).

На

количество типов не накладывается ограничений, оно зависит от специфики

приложения. Система типов в UIMA может быть организована в иерархию (таксономию). Например “компания”

может быть подтипом “огранизации”, а “группа существительного” – подтипом “узла

синтаксического разбора” (ParseNode).

Предположим, что тип “Person” описан как подтип аннотации (subtype of annotation). Аннотатор, например, может создать аннотацию “Person”, обнаружив упоминание о person между позициями 141 и 143 в документе D102. Аннотатор может создать и другую аннотацию person, обнаружив соответствующее упоминание между позициями 101 и 112. В структуре CAS может быть записана утверждение (statement), которое явно устанавливает, что оба фрагмента(span) ссылаются на одну и ту же сущность.

Для представления такого рода информации в систему типов вводится тип “сущность”. Этот тип – не аннатация. Ссылки на объект могут быть как в пределах одного документа, так в пределах коллекции документов (кросс-ссылки). Тип сущность имет свойство “вхождения” (occurrences), указывающее на все аннотации, рассматриваемые как упоминания о некоторой сущности.

Фрагменты, аннотированные как P1 и P2 могут иметь вид "Fred Center" и "He" соответственно. UIMA включает возможности для разрешения такого рода анафорических сылок путем указания, что эти аннотации ссыдаются на один и тот же объект.

UIMA поддерживает анализ, позволяющий одновременно иметь на документ несколько взглядов (multiple views), обеспечивая многомодальность обработки. Для того, чтобы сослаться на определенный “взгляд”, используется “субъект анализа” (subject of analysis - Sofa). Следовательно CAS может содержать один или несколько SOF, а результаты анализа представляют описание объекта для каждого.

Аннотатор – это один из компонентов UIMA. В архитектуру системы входит много других компонент, но все они требуют двух частей для своей реализации:

1. Декларативная часть и

2. Кодовая часть

Декларативная часть содержит метаданные, описывающие компонент, его идентичность(identity), структуру, поведение и называется “дескриптор компонента” (Component Descriptor). Дескрипторы компонента представлены в XML. Кодовая часть реализует алгоритм, она может быть программой на Java.

3.8.2. Пример простого приложения в UIMA

В качестве простого примера приложения UIM рассматривается Искатель Встреч (Meeting Finder). Это приложение анализирует e-mail пользователя на предмет поиска встреч, их времени, места, участников и пытается выявить основное содержание встречи. Искатель Встреч выполняет следующие задачи:

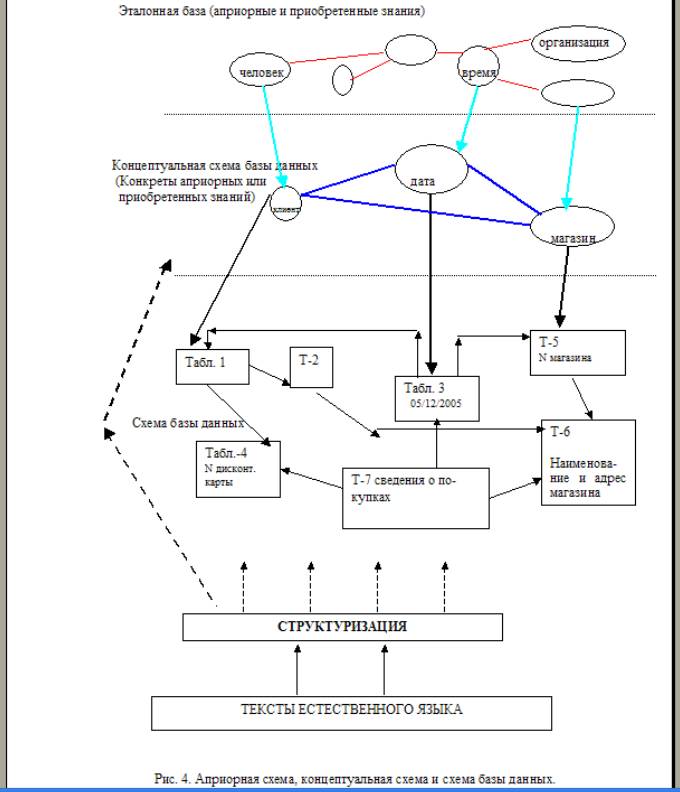

1. Доступ к документам: чтение e-mail сообщений электронной почты